Une évolution majeure :

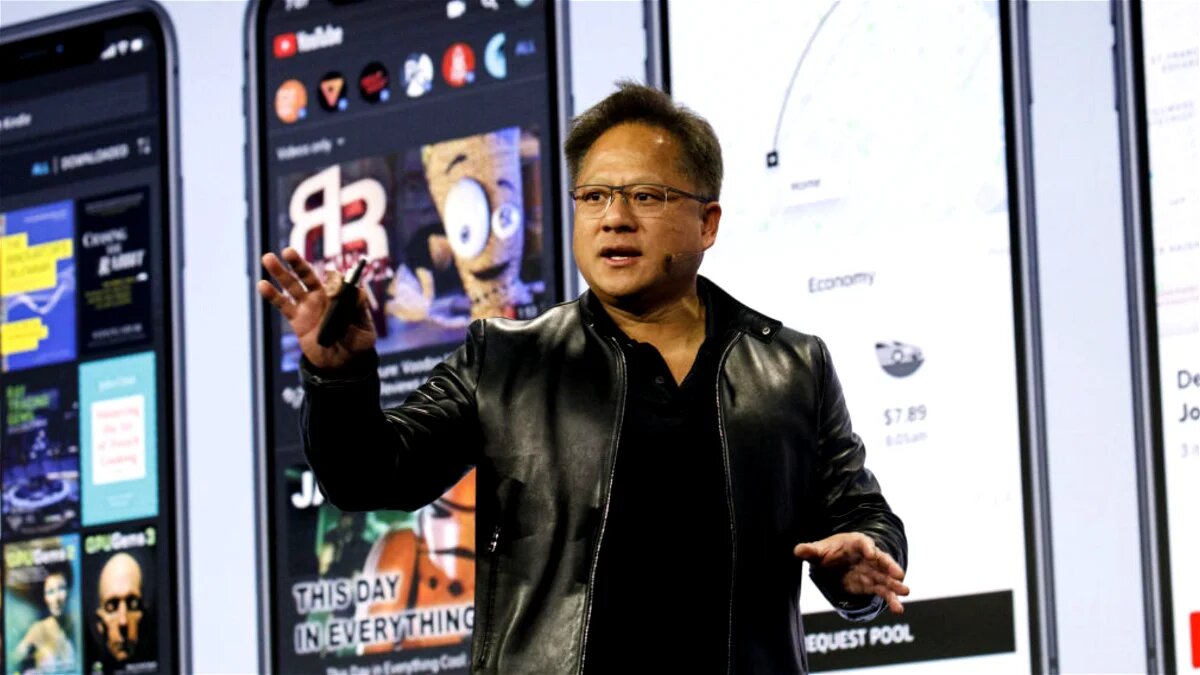

La H200 représente une amélioration significative de la puce H100, célèbre pour avoir été utilisée par OpenAI dans l'entraînement du modèle de langage avancé GPT-4. Cette puce est devenue un acteur clé, fortement convoité par les géants technologiques, tant publics que privés. En tant que ressource stratégique, elle constitue une manne financière, étant donné que des milliers d'exemplaires de la H100, chacun coûtant entre 25 000 et 40 000 dollars, sont nécessaires pour entraîner une IA.

Caractéristiques techniques :

Techniquement parlant, la H200 dispose de 141 Go de mémoire de nouvelle génération "HBM3". Cette capacité accrue améliore considérablement la phase d'inférence, permettant le traitement efficace de vastes ensembles de données pour générer du contenu pertinent, incluant désormais des images et des sons, et non plus seulement du texte. Cette avancée technique renforce les performances de ChatGPT et d'autres modèles d'IA similaires. Nvidia a annoncé que la H200 générera des résultats presque deux fois plus rapidement que son prédécesseur, tout en restant compatible avec ce dernier.

Santé financière et perspectives :

Nvidia, qui a récemment rejoint le club exclusif des entreprises valorisées à plus de 1 000 milliards de dollars, affiche une santé financière robuste. Ses ventes globales ont augmenté de 171 % en glissement annuel, avec un bénéfice net de 6,19 milliards de dollars en août dernier. Cependant, la compétition dans le domaine des puces pour l'IA est féroce, et la H200, attendue sur le marché au deuxième trimestre de 2024, sera confrontée au GPU MI300X d'AMD, présenté en juin dernier.

La course à la puissance de calcul continue :

La course à la puissance de calcul dans le domaine des puces pour l'IA est lancée, avec les fabricants rivalisant pour développer des modèles de plus en plus performants afin de répondre à la demande croissante pour l'IA. La H200 marque une étape significative dans cette évolution, ouvrant la voie à des avancées majeures dans le domaine de l'intelligence artificielle.

La H200 représente une amélioration significative de la puce H100, célèbre pour avoir été utilisée par OpenAI dans l'entraînement du modèle de langage avancé GPT-4. Cette puce est devenue un acteur clé, fortement convoité par les géants technologiques, tant publics que privés. En tant que ressource stratégique, elle constitue une manne financière, étant donné que des milliers d'exemplaires de la H100, chacun coûtant entre 25 000 et 40 000 dollars, sont nécessaires pour entraîner une IA.

Caractéristiques techniques :

Techniquement parlant, la H200 dispose de 141 Go de mémoire de nouvelle génération "HBM3". Cette capacité accrue améliore considérablement la phase d'inférence, permettant le traitement efficace de vastes ensembles de données pour générer du contenu pertinent, incluant désormais des images et des sons, et non plus seulement du texte. Cette avancée technique renforce les performances de ChatGPT et d'autres modèles d'IA similaires. Nvidia a annoncé que la H200 générera des résultats presque deux fois plus rapidement que son prédécesseur, tout en restant compatible avec ce dernier.

Santé financière et perspectives :

Nvidia, qui a récemment rejoint le club exclusif des entreprises valorisées à plus de 1 000 milliards de dollars, affiche une santé financière robuste. Ses ventes globales ont augmenté de 171 % en glissement annuel, avec un bénéfice net de 6,19 milliards de dollars en août dernier. Cependant, la compétition dans le domaine des puces pour l'IA est féroce, et la H200, attendue sur le marché au deuxième trimestre de 2024, sera confrontée au GPU MI300X d'AMD, présenté en juin dernier.

La course à la puissance de calcul continue :

La course à la puissance de calcul dans le domaine des puces pour l'IA est lancée, avec les fabricants rivalisant pour développer des modèles de plus en plus performants afin de répondre à la demande croissante pour l'IA. La H200 marque une étape significative dans cette évolution, ouvrant la voie à des avancées majeures dans le domaine de l'intelligence artificielle.

L'accueil

L'accueil